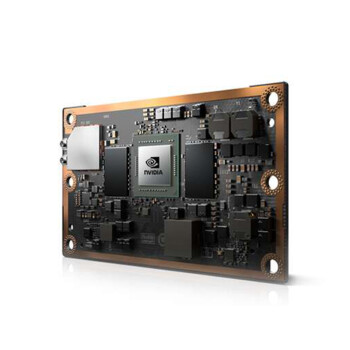

最近很多客戶在問A100的參數呀,其實這款顯卡在AI訓練和大模型部署上確實挺能打的。咱們先聊聊它的核心架構吧,A100用的是Ampere架構,3072個CUDA核心,算力直接拉到9.7 TFLOPS,比上一代提升了不少吶。

顯存這塊,A100上了HBM2,容量高達40GB,帶寬能飆到1.6TB/s。對于需要處理大量數據的場景,比如自動駕駛或者醫療影像分析,這種配置簡直是神器啊。不過,顯存雖然大,散熱也得跟上,要不然長時間高負載運行容易出問題。

再來說說它的RT Core和Tensor Core,A100的光追性能和AI推理能力都很強。尤其是在大模型訓練里,Tensor Core的利用率能達到90%以上。咱們有不少客戶用A100做GPT-3的訓練,反饋都說效率提升很明顯。

A100的價格波動規律

A100目前的市場價大概在15萬左右,但是是這個價格也不是一成不變的。根據海關數據和市場供需情況,Q2的價格通常會下調15%左右。如果你打算采購,建議多關注一下庫存和渠道,選對時機能省不少錢吶。

說到渠道,咱們一般推薦優先選擇品牌直供,其次是保稅倉,再往下就是OEM和拆機件了。這幾種渠道的性價比和風險都不一樣,采購前得根據實際需求和預算好好權衡一下。

A100的采購策略

對于企業級采購來說,A100的集群部署方案是個重點。NVIDIA Magnum IO架構支持多卡管理,能大幅提升整體算力。不過,集群部署的成本也得算清楚,除了顯卡本身,電費和散熱也是大頭。按0.8元/度算,一張A100一年光是電費就得燒掉好幾千塊。

換代周期這塊,一般建議2.3年左右。畢竟摩爾定律擺在那兒,技術進步太快,不及時更新設備很容易被市場淘汰。當然,如果你的業務對算力要求沒那么高,適當延長期限也是可以的。

開發者如何挑選A100

開發者用A100的話,框架適配是個關鍵。PyTorch和TensorFlow的CUDA版本得匹配好,要不然運行效率會大打折扣。另外,故障處理也得提前準備,比如ERROR 43或者0x00000116這種常見報錯,最好整理個代碼庫,方便快速解決問題。

保修服務也得看仔細了,華碩、微星和技嘉的響應速度和服務范圍都不一樣。A100這種高端卡,售后保障很重要,萬一出問題了能快速解決,不至于影響業務進度。

A100的參數和性能雖然硬核,但是是采購時得多方面考慮,從價格、渠道到應用場景都得琢磨透。如果你還在猶豫,不妨先找個樣品試試,看看實際效果再決定。