AI算力需求的爆發式增長使得英偉達顯卡成為業界焦點,尤其是A100、H100等專業計算卡與4090等消費級旗艦的供需動態牽動無數采購商神經。針對當前我國市場最關注的英偉達顯卡性能排序問題,我們結合最新測試數據和實際應用場景,剖析不同型號的核心優勢與適用領域。

一、英偉達顯卡性能排名與關鍵差異

在專業計算領域,H200以4.8TB/s的超高帶寬和141GB的HBM3顯存位居榜首,單精度浮點性能達1979 TFLOPS,主要面向大型語言模型訓練。H100緊隨其后,其Transformer引擎可加速LLM訓練速度3倍,售價約220萬元。定位中端的A100與A800均配備40GB HBM2顯存,但A800的NVLink帶寬被限制在400GB/s,更適合普通數據中心部署。

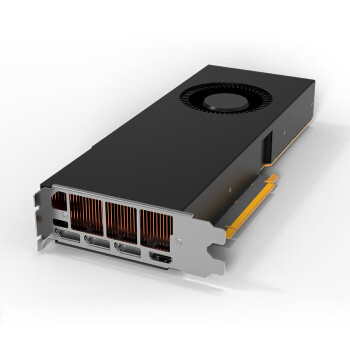

消費級顯卡中,RTX 4090以16384個CUDA核心和24GB GDDR6X顯存領跑,1.9萬元的售價提供83 TFLOPS算力,是性價比最高的AI推理卡。值得注意的是,渦輪版的4090更適合機架式部署,其散熱設計允許密集安裝。

二、如何選擇適合AI訓練的英偉達顯卡?

大模型訓練首選H200或H100,二者的FB32運算模式可提升矩陣計算效率5倍。中小型企業可考慮租賃A100集群,單卡15萬的價格配合NVLink實現多卡并聯時,8卡系統可提供5PetaFLOPS的算力。推理場景下,4張4090組成的系統成本僅7萬元,卻能提供330TFLOPS算力,特別適合Stable Diffusion等生成式AI應用。

具體選擇時需關注三個指標:首先檢查顯存帶寬,H200的4.8TB/s比A100高2.3倍;其次對比TF32精度性能,H100在此模式下達989TFLOPS;最后考慮電源需求,H200需配置1200W以上電源。

三、英偉達顯卡的現貨采購策略

目前H100等高端卡的供貨周期普遍在3個月以上,部分渠道現貨需加價30%。正規代理渠道的A100庫存相對充足,但需提供最終用戶承諾書。對于急需部署的企業,考慮采用4090臨時方案,其24GB顯存可承載70億參數模型。

采購時務必驗證三項憑證:官網可查的SN碼、代理授權證書、原廠靜電袋封裝。警惕所謂"行業定制版",這類產品往往閹割了關鍵計算單元。

四、實戰中的配置優化方案

雙路H100服務器配置推薦采用英特爾至強8462Y處理器,搭配1TB DDR5內存,通過NVSwitch實現300GB/s的卡間互聯。散熱需采用液冷方案,每臺機柜功耗控制在42kW以內。對于使用4090搭建推理集群的情況,建議選用超微4029GP-TRT機箱,支持8卡全高全長的部署,需配合2000W鉑金電源。

軟件層面需注意:CUDA 12.4對H200有新優化,TensorRT 9.3可提升4090的INT8推理性能40%。在Ubuntu 22.04系統下,需手動安裝dkms驅動才能啟用全部計算單元。