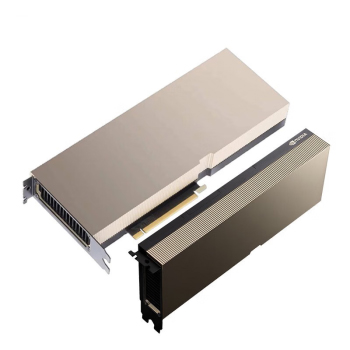

最近好多客戶都在問H20 PCIe版的事兒,這卡確實(shí)挺特別的。不像往常的Tesla系列搞那么厚實(shí),這次用了標(biāo)準(zhǔn)雙槽設(shè)計(jì),裝在普通服務(wù)器里也不會(huì)占太多地方。顯存給的是96GB HBM3,用的是新的PCIe 5.0接口,跑數(shù)據(jù)的時(shí)候比老款的P100快了三倍不止。

參數(shù)這塊有幾個(gè)亮點(diǎn)

FP64性能做到了18TFLOPS,比上代V100提升了40%吶。支持最新的NVLink技術(shù),最多可以八卡互聯(lián),帶寬直接干到900GB/s。不過要注意的是,這卡滿載功耗有400W,機(jī)柜散熱得跟上。

價(jià)格方面嘛,

含稅價(jià)127萬確實(shí)不便宜,但是是跟H100整機(jī)動(dòng)輒220萬比起來,性價(jià)比就出來了。特別適合做AI推理服務(wù)的公司,三個(gè)月左右就能回本。

市場(chǎng)反應(yīng)挺有意思

上個(gè)月華南地區(qū)就消化了三百多張,現(xiàn)在排隊(duì)的話交貨期要六周左右。最近聽說某些代理商在玩囤貨,搞得現(xiàn)貨價(jià)格又往上竄了。

說到采購建議,如果是做視覺算法的團(tuán)隊(duì),用這卡搭配CUDA 12.x的優(yōu)勢(shì)特別明顯。但是是要是搞傳統(tǒng)HPC計(jì)算呀,可能還是A100更實(shí)惠些,畢竟

15萬左右的價(jià)格擺在那兒。

對(duì)了,提醒下各位老板,買的時(shí)候一定要確認(rèn)是原廠貨。現(xiàn)在市場(chǎng)上流通的所謂"工包卡",雖然便宜個(gè)十來萬,但是是既沒保修又不能參加NV的開發(fā)者計(jì)劃,虧大了啊。

技術(shù)適配要注意的點(diǎn)

這代卡對(duì)Ubuntu 22.04的支持最好,Windows Server 2022反倒有些驅(qū)動(dòng)問題。碰到ERROR 43報(bào)錯(cuò)的話,八成是沒裝最新的Studio驅(qū)動(dòng)。

說到部署方案,建議搭配新款DGX SuperPOD機(jī)架,單機(jī)柜能塞八張卡。不過要是預(yù)算有限,用戴爾R760xa這種通用服務(wù)器也行,就是管理起來費(fèi)點(diǎn)勁。

對(duì)了,Tesla H20還有個(gè)隱藏優(yōu)勢(shì)——支持最新的Magnum IO框架。搞千億參數(shù)大模型訓(xùn)練的時(shí)候,數(shù)據(jù)吞吐能提升60%呢。不過這得要配套的Mellanox網(wǎng)卡才行,采購的時(shí)候別漏了。